Methoden zur Strukturierung, Verwaltung und Visualisierung großer 3D-Punktewolken und Volumendaten

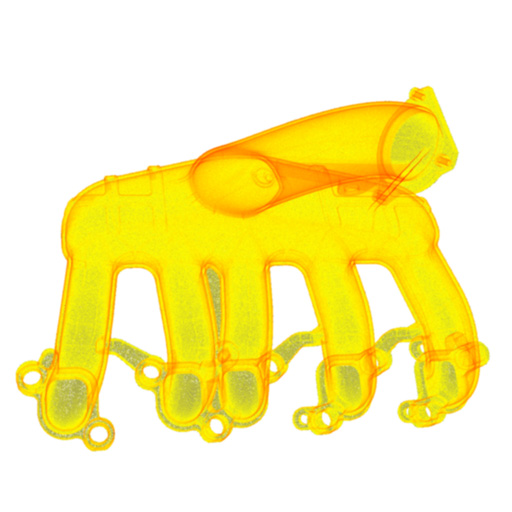

Methoden und Verfahren zur Erfassung von 3D-Daten sind inzwischen in der industriellen Fertigung für verschiedene Anwendungen etabliert. Insbesondere im Rahmen der Qualitätsprüfung werden Computer-Tomographen (CT) zur Erfassung von Volumendaten für die Abbildung des Bauteilinneren oder optische 3D-Messverfahren für die Bestimmung der äußeren geometrischen Form genutzt. Die Erzeugung eines detailgetreuen digitalen Abbildes mit hoher Präzision, Auflösung und Geschwindigkeit zählen zu den großen Vorzügen der Messverfahren. Jedoch stellen die erzeugten großen Datenmengen für eine effiziente Visualisierung und Verarbeitung an das Datenmanagement und die Methoden zur Verarbeitung erhebliche Anforderungen.

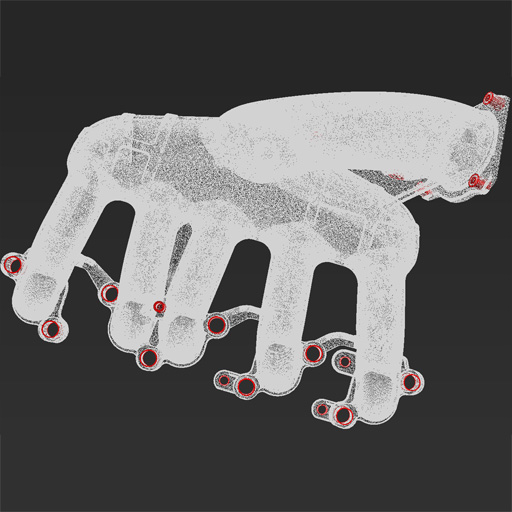

Für typische Anwendungsszenarien werden mit aktuellen Geräten mehrere hunderte Millionen bis einige Milliarden 3D-Messdatenpunkten erzeugt. Der dafür erforderliche Datenspeicher beträgt ca. 50-100 Gigabyte und übersteigt damit die Kapazität des Arbeits- und Grafikkartenspeicher von Standardhardware um ein Vielfaches. Um trotzdem eine effiziente Visualisierung und Verarbeitung der 3D-Datenmengen zu erreichen werden Verfahren eingesetzt, welche die 3D-Datenmenge zuvor derart strukturieren, dass diese sukzessive in kleineren und technisch handhabbaren Datenblöcken verarbeitet werden kann. Für die Visualisierung wird zudem die Tatsache genutzt, dass nur diejenigen 3D-Punkte angezeigt werden müssen, die aktuell im Fokus des Anwenders stehen. Zusätzlich ergibt sich eine weitere Limitierung der erforderlichen Daten durch ein endlich hohes Auflösungsvermögen des genutzten Bildschirms. Für die Selektion der erforderlichen Teilmenge an 3D-Punkten aus der Gesamtdatenmenge sind für eine schnelle Verarbeitung hocheffiziente Datenstrukturen eine zwingende Voraussetzung.

Strukturierung großer 3D-Datenmengen

Die erforderliche Strukturierung der Daten basiert im Allgemeinen auf einer hierarchischen, räumlichen Unterteilung der Daten mithilfe algorithmischer Bäume, welche das Messvolumen in immer kleinere Volumen separiert. Die oberen Hierarchien dieser Baumstrukturen sind gering aufgelöst und verwalten Repräsentanten der höher aufgelösten Teilmenge der unteren Hierarchien. Indem man den Verzweigungen einer Baumstruktur nach unten folgt, adressiert man sukzessive sich räumlich verkleinernde Untermengen der Gesamtdatenmenge.

Ein typischer Vertreter einer solchen Baumstruktur ist der sogenannte Octree, mit dem das gesamte Messvolumen zunächst in acht Würfel (auch Voxel genannt) unterteilt wird. Diese werden in den nächsten Hierarchien jeweils weiter unterteilt bis in jedem Voxel nur noch wenige 3D-Datenpunkte enthalten sind. Eine ähnliche Strategie wird mit binären Bäumen verfolgt. Binärbäume unterteilen die Gesamtdatenmenge sukzessive in zwei möglichst gleich große Teilmengen. Ein typischer Vertreter hierfür ist der kD-Baum, mit dem eine 3D-Datenmenge nacheinander folgend mittig entlang der x-, y- und z-Koordinaten wiederholt unterteilt wird.

Baumstrukturen ermöglichen es letztlich, eine Teilmenge der Gesamtdatenmenge schnell und gezielt auszuwählen ohne die restlichen Daten ebenfalls betrachten zu müssen. Die Teilmengen werden in ihrer Größe derart definiert, dass sie der Größe des verfügbaren Arbeits- und Grafikkartenspeichers angemessen sind.